Мои наблюдения за роботом Яндекса

Опубликовано: 02.09.2018

![5 ОДЕРЖИМЫХ ЛЮДЕЙ СНЯТЫХ НА КАМЕРУ [Черный кот] видео Мои наблюдения за роботом Яндекса](https://i.ytimg.com/vi/qQFdE6jxJAo/mqdefault.jpg)

Здравствуйте, постоянные читатели блога и те, кто заглянул сюда впервые. Сегодня хочется рассказать немного о своих наблюдениях за роботом Яндекса. Может быть, то о чем я расскажу, не будет для вас новым, но мне кажется, что моя небольшая заметка может быть полезна начинающим владельцам сайтов.

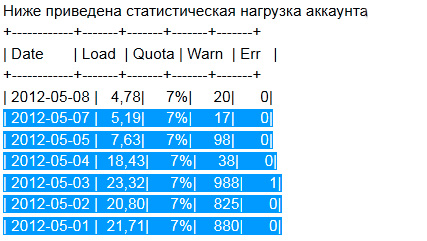

Хорошие хостинговые компании анализируют нагрузку на свои сервера и могут предоставлять некоторую статистику пользователям сайтов. Например, хостинговая компания СпейсВэб (можете прочитать обзор хостинга SpaceWeb ), предоставляет пользователям статистику нагрузки на аккаунты, которая может быть очень полезна. Так вот, в статистике одного из моих сайтов я заметил, что резко увеличилось число некритичных превышений нагрузки на процессор. А вместе с тем, незначительно увеличилось число критичных превышений нагрузки на процессор . То есть, если поднимается нагрузка на сервер сайта, при той же посещаемости, то это не очень хорошо. В первую очередь это может говорить о не отлаженных скриптах. Но я был уверен что причина повышения нагрузок кроется не в этом.

АНТИФИЛОСОФИЯ.Человек – это робот. Доказательство

Про индексирующего робота поисковой системы Яндекс

Где-то как-то я читал, что индексирующий робот поисковых систем может вызывать значительную нагрузку своими частыми обращениями к сайту при его индексации. А иногда, это доходит до того, что хостинговая система может забанить робота поисковой системы по ip адресу, и тем самым напрямую ограничить доступ поисковому роботу к сайту. Кстати, у меня уже такое было, и в панели веб-мастера, я видел сообщение, что доступ к сайту для робота запрещен в файле robots.txt, хотя на самом деле в моем файле запрета для доступа роботам не было. Так вот, чтобы попытаться избежать подобной ситуации в будущем, я попробовал контролировать обращения поисковых роботов к сайту. Я сделал следующее, в файле robots.txt я прописал следующую строку:

7 ЛАЙФХАКОВ КОТОРЫЕ УПРОСТЯТ ЖИЗНЬ КОТА!

Crawl-delay: 2

Этой строкой я ограничил свободное обращение Яндекс робота к моему сайту, и теперь он может обращаться к сайту только через каждые две секунды.

Понижение нагрузки на сайт

Таким образом я достиг того, что число некритичных превышений нагрузки на сервер упало до нормы, а число критичных превышений нагрузки на сервер упало до нуля. Также, теперь ip роботов Яндекса не попадает в бан хостинговой компании, и сайт прекрасно индексируется.

На картинке выше, я показал статистику нагрузки. Сами можете наблюдать, как число некритичных превышений нагрузки упало с 988 до 17-20. Вот так. И это все благодаря одной строчке в файле robots.txt .

Мне кажется подобная настройка сайта и управление роботом поисковой системы Яндекс будет полезна новеньким сайтам с небольшой посещаемостью.

Подписывайтесь и получайте полезные статьи на почту!